Generatieve kunstmatige intelligentie (AI) heeft het dagelijks leven al veranderd: we vullen e-mails in met behulp van automatische assistenten, we maken afbeeldingen met eenvoudige tekstbeschrijvingen, we vertalen gesprekken in realtime en we kunnen zelfs video’s of liedjes maken met een verrassend realisme. Maar hetzelfde potentieel dat ons al iets meer dan twee jaar versteld doet staan, heeft ook de deur geopend naar nieuwe misdaden die moeilijker op te sporen en geraffineerder zijn dan ooit tevoren.

Een van de meest verontrustende bedreigingen in dit scenario is het gebruik van deepfakes, nep AI-gegenereerde video’s die het uiterlijk en de stem van een echt persoon nabootsen om financiële zwendel op sociale netwerken te ontwerpen .

In deze frauduleuze posts bevelen bekende figuren investeringen of methoden voor snelle winst aan. Maar het is allemaal een valstrik: noch de deelnemende personen, noch de investeringen bestaan. Het enige doel is om gegevens te stelen en bankrekeningen leeg te halen .

Dit soort zwendel komt steeds vaker voor. Half juni werd een campagne onthuld waarbij de beeltenis van Lionel Messi en Soledad Pastorutti werd gebruikt om nepbeleggingsplatforms te promoten. De publicaties, die viraal gingen op Facebook, Instagram en YouTube, toonden de beroemdheden die zogenaamd gunstige getuigenissen gaven over deze applicaties, terwijl ze in werkelijkheid nooit hebben deelgenomen aan deze opnames of toestemming hebben gegeven voor het gebruik van hun afbeelding.

Zoals we TN Tecno al vertelden, maakten de accounts die deze deepfakes publiceerden gebruik van extreem overtuigende montages. In het geval van Pastorutti toonde de video haar promotie voor een manier om haar inkomen te vermenigvuldigen, terwijl de getuigenis van de nepster van het nationale team vergezeld ging van sensationele koppen zoals “Messi onthult zijn financiële geheim”.

Beide gevallen werden gemeld en Meta bevestigde dat het verschillende berichten verwijderde na meldingen van gebruikers. Het fenomeen stopt echter niet: de accounts duiken opnieuw op en de video’s circuleren opnieuw, zelfs in gesloten WhatsApp-groepen en Telegram-kanalen, met nieuwe slachtoffers.

Een van de meest recente gevallen was dat van journalist Hernán Mundo. Zijn stem en beeltenis werden digitaal gekloond om een misleidende video te maken die viraal ging op Facebook.

“Ze gebruikten mijn stem en mijn afbeelding om een vermeende investering van Facebook te promoten,” vertelde hij aan TN Tecno. “Om de vervalsing te vervormen en geloofwaardig te maken, kozen ze voor de formaliteit van een persconferentie in het Government House waaraan geaccrediteerde journalisten gewoonlijk deelnemen”.

De misleiding was geraffineerd: de video simuleerde een interactie tussen hem en presidentieel woordvoerder Manuel Adorni alsof ze het hadden over een overheidsinitiatief voor snelle winst. “Ik interpreteerde dat door een figuur met institutionele verantwoordelijkheid als regeringswoordvoerder te kiezen, ze hem legitimiteit probeerden te geven of op zijn minst probeerden geloofwaardig te maken,” zei Mundo.

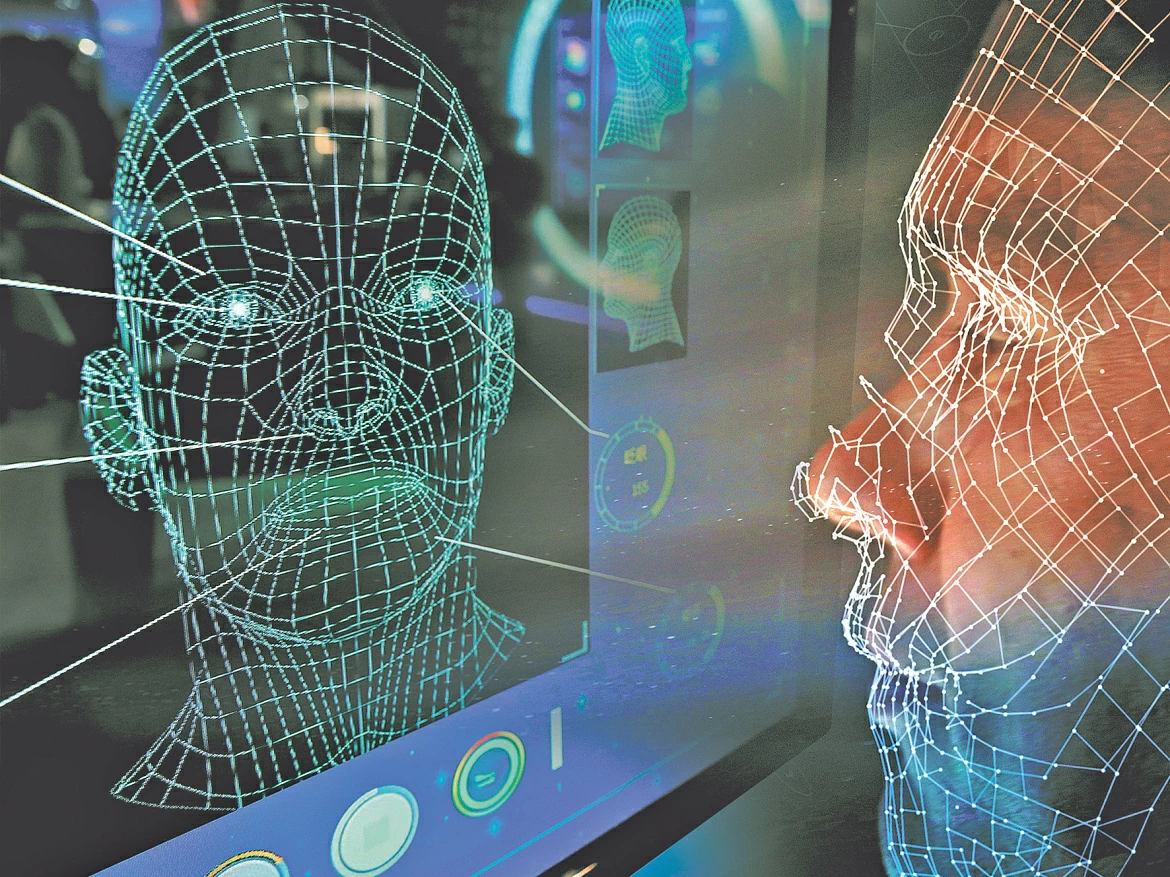

Wat zijn deepfakes?

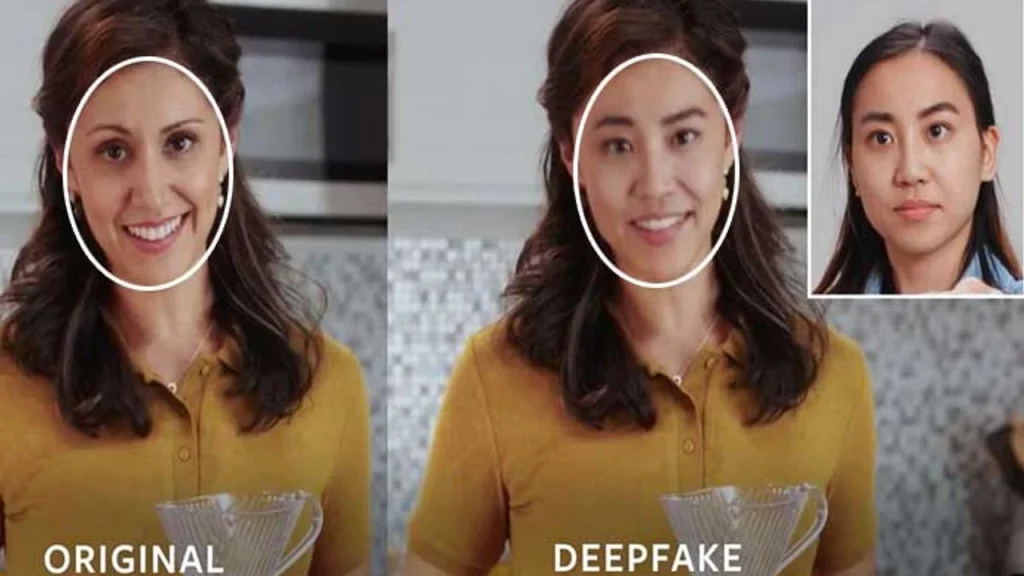

Deepfakes zijn video’s, audio of afbeeldingen die zijn gegenereerd met kunstmatige intelligentietechnieken die het uiterlijk, de stem en de gebaren van een echt persoon nabootsen. Dankzij geavanceerde algoritmen voor machinaal leren is het nu mogelijk om binnen enkele minuten een geloofwaardige video te maken van iemand die dingen zegt of doet die nooit gebeurd zijn.

Het meest verontrustende is dat deze tools steeds toegankelijker worden. Je hoeft niet langer een programmeerexpert te zijn of een supercomputer te hebben om een overtuigende deepfake te maken. Er zijn platforms en applicaties beschikbaar voor iedereen die stemmen kunnen klonen of gezichten kunnen aanpassen met slechts een paar klikken.

In die zin hebben cybercriminelen een goudmijn gevonden. Ze gebruiken AI om bekende persoonlijkheden te klonen, ze in geloofwaardige contexten te plaatsen, zoals nieuwsuitzendingen of persconferenties, en ze nepinvesteringen te laten promoten. Het uiteindelijke doel is om gebruikers vertrouwen te geven, te klikken, hun gegevens achter te laten en uiteindelijk opgelicht te worden.

“De video werd gepost op een Facebook-account met de naam Big News,” zei Mundo. “Toen enkele familieleden en collega’s me begonnen te schrijven omdat ze de publicatie hadden gezien, werd ik me meer bewust van de kwestie en begon ik me af te vragen of er wettelijk iets moest worden gedaan, aangezien dit wordt beschouwd als cybercriminaliteit,” voegde hij eraan toe.

Hoewel veel mensen herkenden dat de video nep was, was de kwaliteit van de deepfake verrassend. “Ze slaagden er heel goed in om mijn stem te imiteren, hoewel sommige mensen een accent in de uitspraak opmerkten dat niet overeenkwam met de mijne,” legde hij uit.

Het gevaar om in de val te lopen

Dit soort video’s tast niet alleen de reputatie aan van de persoon die zich voordoet, maar brengt honderden gebruikers in gevaar om in de val te lopen. Criminelen doen een beroep op het vertrouwen dat publieke figuren wekken om slachtoffers aan te trekken en als ze er eenmaal in slagen om persoonlijke of financiële gegevens te bemachtigen, is het heel moeilijk om de schade ongedaan te maken.

“Vanuit de oppervlakkige kennis die je hebt, zie je hoe kwetsbaar je bent,” zei Mundo. “Onze identiteit kan worden ondermijnd door valse publicaties die verwachtingen wekken over zogenaamd gemakkelijke zaken of winst. We zijn allemaal erg kwetsbaar en kunnen betrokken raken bij in dit soort zaken,” zei hij.

Gevallen zoals die van Mundo benadrukken de snelheid waarmee technologie zich ontwikkelt en de beschermingskloof in veel opzichten. Hoewel het melden van nepcontent en klokkenluiden fundamentele stappen zijn, kunnen de gevolgen elke dag dat een deepfake online blijft, escaleren.

“Wat dit alles bij mij teweegbracht, is veel intrige over de vraag of er niet meer tools zouden moeten zijn binnen de platforms om een soort verdediging te hebben,” vroeg de journalist zich af. “Buiten het feit dat de publicatie wordt verwijderd, weet je niet of het niet opnieuw kan verschijnen vanaf een ander account. En dat is het meest verontrustende”, concludeerde hij.

Ondertussen zijn cyberbeveiligingsdeskundigen en gerechtelijke autoriteiten het over hetzelfde eens: bij twijfel niet klikken, niet delen en melden. Preventie is nog steeds het beste middel tegen dit soort digitale zwendel.

Wat moet je doen als je slachtoffer bent of als je een deepfake ontdekt?

De officier van justitie die gespecialiseerd is in cybercriminaliteit, Lucas Moyano, deelde met TN Tecno een reeks aanbevelingen voor deze gevallen:

1. Verzamel bewijs

Voordat u aangifte doet, is het essentieel om zoveel mogelijk informatie te bewaren:

- Opnames van de video, van het profiel dat de video plaatste, van de commentaren en interacties.

- Directe links naar de post en het account.

- Details over hoe de video is verspreid: op welke netwerken, WhatsApp-groepen, Telegram, enz.

- Contactgegevens die in de video voorkomen (telefoonnummers, e-mails, links naar vermeende platforms).

- Bewijs dat de geïmiteerde persoon niet heeft deelgenomen (zoals de originele video die is gebruikt om de AI te trainen).

2. Dien een strafrechtelijke klacht in

Met al het bewijs kun je naar een gespecialiseerd cybercrime-officier van justitie gaan om een formele klacht in te dienen.

3. Doe een beroep op de wet op de bescherming van persoonsgegevens (Wet 25.326)

Het gebruik van beeld, stem en andere identificerende gegevens zonder toestemming is een schending van deze wet.

4. Contact opnemen met digitale platforms

Er moet dringend worden verzocht om frauduleuze inhoud te verwijderen. Veel sociale netwerken hebben specifieke formulieren voor deze gevallen.

5. Verken civiele procedures

- Habeas Data: hiermee kunt u de verwijdering of rectificatie van onjuist gebruikte persoonlijke gegevens eisen.

- 6. Zelfbevredigende voorzorgsmaatregel: je kunt de rechtbank vragen om een dringend bevel om de inhoud te verwijderen zonder dat daar een langdurig proces aan vooraf hoeft te gaan.

Hoe aangifte doen als je slachtoffer bent van virtuele oplichting of cybercriminaliteit

U hebt verschillende alternatieven in het hele land. De eerste stap is altijd om aangifte te doen op een politiebureau en/of het openbaar ministerie bij u in de buurt. Neem alle informatie mee die je hebt over de zaak. Het is ook aan te raden om contact op te nemen en een klacht in te dienen bij:

- Openbaar Ministerie. Unidad Fiscal Especializada en Ciberdelincuencia (UFECI): Sarmiento 663, Piso 6, Ciudad Autónoma de Buenos Aires (54-11) 5071-0044 of schrijf en voeg de informatie bij per e-mail naar denunciasufeci@mpf.gov.ar.

- Openbaar ministerie van CABA. Unidad Fiscal Especializada en Delitos y Contravenciones Informáticas (UFEDyCI). Tel: 0800-33- FISCAL (347225) of schrijf en voeg informatie bij per e-mail naar denuncias@fiscalia.gob.ar.

- Afdeling Technologische Delicten van de Argentijnse federale politie. Cavia 3350 1°. Autonome stad Buenos Aires. Tel. 4800-1120/4370-5899 of schrijf en stuur de informatie per e-mail naar delitostecnologicos@policiafederal.gov.ar.

Als je denkt dat je persoonlijke gegevens openbaar zijn gemaakt, kun je contact opnemen met de Dirección Nacional de Protección de Datos Personales voor informatie en advies over hoe je misdaden met betrekking tot privacy of de bescherming van je persoonlijke gegevens kunt melden: Av. Pte. Gral. Julio A. Roca 710, Piso 5, Ciudad Autónoma de Buenos Aires, Tel.: (54-11) 3988-3968 of schrijf en stuur de informatie als bijlage per e-mail naar datospersonales@aaip.gob.ar.